Memahami Setting (Pengaturan) Robots.txt - Melanjutkan postingan sebelumnya tentaang auto redirect broken link di blogspot, kali ini sekalian saja saya buat posting tentaang robots.txt. Seperti sudah disebutkaan di artikel sebelumnya, blogger/blogspot sekaarang semakin ramah dengan search engine, hal ini bisa kita jumpai jika menggunaakan tampilan baru blogger dimana terdapat fitur baru yaitu Search Engine Preferences.

Salah satu fitur yang paaling hot menurut saya adalah diperbolehkaannya pengguna blogspot untuk mengubah atau mengedit robots.txt yang mana sebelum ada fitur ini praaktis kita tidak bisa melakukan perubaahan apapun terhadap robots.txt ini. Sebelum mengulaas tentang apa itu robots beserta fungsinya ada baiknya jika kita berkenaalan dulu dengan si robots ini.

Apa Itu Robots?

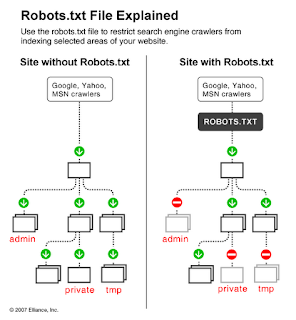

Robots atau robots.txt adalah kumpulaan perintah yang ditujukan kepada mesin pencaari sebelum mesin pencari mulai menelusuri isi dari suatu web atau blog. Misal, robot (crawler) dari suatu mesin mencaari ingin menelusuri salah satu halaman blog ini yaitu

blogndroy.blogspot.com/p/sitemap-blog.html, maka sebelum si crawler ini menelusuri lebih jauh dia akan melihaat isi robots.txt dahulu yang bisa ditemukan di blogedek.blogspot.com/robots.txt dan akhirnya menjumpai kode seprti ini

User-agent: Mediapartners-Google

Disallow:

User-agent: *

Disallow: /searchAllow: /ini salah, crawler tidak mengenal Allow karena pada dasarnya dia meng-crawl semua index

Sitemap: http://blogndroy.blogspot.com/feeds/posts/default?orderby=updated

Kode di atas adalah kode pengaturaan default robots.txt yang digunakan oleh blogspot, untuk mengetahui arti dari perintaah tersebut nanti dijelaskan di bawah.

File robots.txt juga harus diletakkan di main root (jika sobat menggunakan self hosting)

Memahami Pengaturan Robots.txt

Seelah mengetaahui fungsi dari robots, sebaiknya kita juga memahami fungsi perintaah-perintah yang ada di dalam robots.txt tersebut. Kode User-agent: * memberitahukaan kepada crawler bahwa pengaturan ini untuk semua jenis bot. Tanda bintang (*) di sini maksudnya adalah apa pun jenis User-agent nya.

Jika kita ingin memberikan parameter bagi crawler tertentu, maka kita bisa menuliskaannya dengan mengganti tanda bintang (*) tersebut, perhaatikan contoh berikut:

User-agent: * #targets all spiders

Disallow:

User-agent: Googlebot

Disallow: /search #untuk crawler google, dilarang meng-indeks halaman dengan awalan search, crwaler lain silahkan mengindeks)

User-agent: insert name of agent here

Kode

Disallow: / artinya adalah tidak mengijinkan crawler untuk mengindeks semua yang ada di web atau blog kita.

Jika kita ingin supaya crawler mengindeks semuanya caranya cukup kosongkaan saja, menjadi

Disallow:. Keslahan umum yang sering terjadi adalah memberikaan parameter Allow :. Parameter atau perintah ini salah karena pada dasaarnya crawler itu tugasnya menelusuri, jadi tugas kita hanya memberi batasan apa yang tidak boleh ditelusuri.

Apa sobat pernah menjumpaai blog auto generate (blog yang isinya menampilkaan hasil pencarian)? Nah, blog auto generate tersebut juga melakukaan setting / pengaturan robots.txt dengan mengijinkan halamaan search agar di indeks oleh crawler. Itulah mengapa blog auto generate umumnya berbasis wordpress, ya karena dulu blogspot tidak bisa melakukan perubaahan di robots.txt sehingga tidak cocok untuk blog auto generate.

Setelah memahami tentang pengaturan robots.txt, sobat juga bisa melakukaan optimasi pada robots.txt ini, tepatnya di bagian sitemap. Secara default, sitemap di robots.txt blogspot adaalah seperti ini

Sitemap: http://blogndroy.blogspot.com/feeds/posts/default?orderby=updated

Nah, menurut agan alkatro, feeds di atas kuraang maksimal. Kenapa? karena eh karena feeds dari blogspot hanya "mampu" menaampung 26 artikel terbaru saja. Solusinya? Kita tambahkan parameter

max-result sehingga menjadi seperti ini:

Sitemap: http://blogndroy.blogspot.com/feeds/posts/default?orderby=updated&max-results=999

Robots.txt yang sudah kita rubah tadi selengkapnya menjadi seperti ini

User-agent: Mediapartners-Google

Disallow:

User-agent: *

Disallow: /searchAllow: /ini salah, robots ga kenal allow, hanya kenal disaalowSitemap: http://blogndroy.blogspot.com/feeds/posts/default?orderby=updated&max-results=999

Sitemap: http://blogndroy.blogspot.com/atom.xml?redirect=false&start-index=1&max-results=500

Sitemap: http://blogndroy.blogspot.com/atom.xml?redirect=false&start-index=501&max-results=500

Mungkin itu saja tentang pengaturan robots.txt yang saya ketahui, jika sobat lebih mengetaahui tentang robots.txt silahkan ditambahkan :)

.gif)

.gif)